Google 所研發的 AI 晶片「TPU」近期動作頻頻,外媒盛傳,Meta 正評估於 2027 年開始在自家資料中心大規模部署 TPU 晶片,這將讓原本在 AI 市場一枝獨秀的輝達感到壓力。面對外界關注,輝達罕見在 X 回應,強調自家最新一代 Blackwell GPU 仍「領先業界一個世代」,重申目前只有輝達的平台能完整支援所有主流 AI 模型與運算場景。

輝達在貼文中直言,與 Google TPU 這類專為單一企業、單一用途設計的 ASIC 晶片相比,Blackwell 在效能、彈性與通用性上更具全面優勢,同時,也表示樂見 Google 在 AI 領域的進展,雙方仍維持合作關係,輝達也持續向 Google 出貨相關產品。

現正最夯:伊朗局勢惡化!美國駐沙烏地首都使館遇襲 川普揚言反擊

由 Google 研發的張量處理單元(TPU)與輝達的圖形處理器(GPU)在設計上有別,兩者在 AI 運算中的角色與定位也截然不同。

GPU 最初是為加速遊戲圖像渲染與視覺特效而設計,強調大量平行處理能力,當機器學習興起時,業界發現 GPU 非常適合 AI 模型訓練所需的大規模運算,進而成為主流應用;TPU 則屬於特定應用積體電路(ASIC),從開發之初便帶有極致的單一目標:專門用於加速神經網路運算中最核心的大規模矩陣乘法。這意味著 TPU 在設計上,以犧牲通用性為代價,換取在特定 AI 任務上的效率。

據外媒《The Information》日前披露,Meta 正與 Google 商談一筆規模達數十億美元的合作案,計畫最快明年起透過 Google Cloud 租用 TPU 運算資源,並不排除在 2027 年導入自家資料中心。消息曝光後,輝達股價一度重挫 3%,也讓市場解讀,Meta 有意分散對單一供應商的高度依賴,若交易最終拍板,其將能有效分散供應風險,同時利用 TPU「量身定做」的優勢,來提升大型語言模型(LLM)的訓練與推理效率。

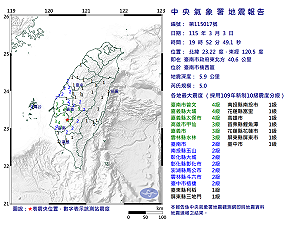

當前熱搜:快訊》19:52臺南市楠西區發生規模5.0有感地震 最大震度臺南市曾文、嘉義縣大埔、嘉義縣太保市4級

分析指出,Meta 是全球資本支出規模最大的 AI 客戶之一,市場預估其 2026 年資本支出恐突破千億美元,其中高達 400~500 億美元將用於 AI 推理與運算晶片建置。因此,尋找第二套穩定供應來源,十分重要。

目前輝達在 AI 晶片市占率仍高達九成以上,短期內霸主地位難以撼動;但 Google 近期明顯加速推動 TPU 商業化,除了開放企業透過 Google Cloud 租用運算資源,本月也正式推出以 TPU 完成訓練的新一代 Gemini 3 模型。Google 強調,市場對 TPU 與輝達 GPU 的需求是同步成長,兩者並非零和關係。

輝達執行長黃仁勳日前在財報會議上也回應指出,Google 依舊是輝達的重要客戶,Gemini 系列模型同樣可在輝達平台上運行,並透露已與 Google DeepMind 執行長哈薩比斯保持溝通。