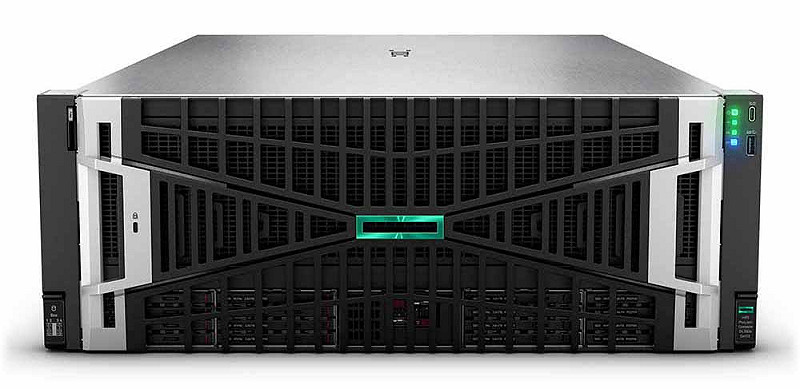

HPE(NYSE:HPE)宣布其NVIDIA AI Computing by HPE 產品組合全面升級,助力各規模企業客戶應對整個AI生命週期的挑戰。此次更新強化了與NVIDIA AI Enterprise的整合,並將最新的NVIDIA AI模型和NVIDIA Blueprints導入HPE Private Cloud AI,讓開發人員能更輕鬆地部署AI應用。HPE也將推出搭載NVIDIA Blackwell加速運算的HPE ProLiant Compute伺服器,以推進生成式、代理型及實體AI工作負載的發展。

HPE與NVIDIA攜手推動AI革命

全站首選:美對伊戰爭耗損嚴重! 8百愛國者導彈、11架MQ-9、3架F-15戰機損失

「HPE致力於為企業提供AI時代所需的工具。」HPE 私有雲與靈活解決方案事業群資深副總裁暨總經理 Cheri Williams 表示,「我們與NVIDIA的合作持續突破創新邊界,提供能釋放生成式、代理型與實體AI價值的解決方案,同時滿足企業工作負載的獨特需求。結合HPE ProLiant伺服器與HPE Private Cloud AI的擴展功能,我們讓組織能以信心與敏捷擁抱AI未來。」

「企業需要靈活且高效的基礎架構,才能跟上現代 AI不斷變化的需求挑戰。」NVIDIA 企業 AI 副總裁 Justin Boitano 表示,「透過搭載 NVIDIA RTX PRO 6000 Blackwell GPU 的 HPE 2U ProLiant 伺服器,企業得以在單一、整合且符合企業級標準的平台上,加速幾乎所有工作負載。」

上市時程:

當前熱搜:朱蒲青觀點》東京巨蛋的一場加油 為何在台灣變成政治戰場?

搭載NVIDIA RTX PRO 6000 Blackwell伺服器版GPU的HPE ProLiant DL385 Gen11和HPE ProLiant Compute DL380a Gen12伺服器即日起開放訂購,並將於2025年9月2日起在全球出貨。

HPE Private Cloud AI對NVIDIA Nemotron模型、Cosmos Reason與NVIDIA Blueprint for VSS 2.4的支援,將於2025年下半年推出。

搭載NVIDIA RTX PRO 6000 Blackwell伺服器版GPU的新一代HPE Private Cloud AI,將於2025年下半年上市。

來看看,搭載NVIDIA Blackwell架構的HPE ProLiant Compute伺服器即將上市,並將提供兩種NVIDIA RTX PRO伺服器配置:

HPE ProLiant DL385 Gen11 伺服器:此款氣冷型伺服器採用全新2U RTX PRO伺服器機型,支援最多兩顆NVIDIA RTX PRO。

6000 Blackwell伺服器版GPU,滿足企業資料中心日益增長的AI需求。

HPE ProLiant Compute DL380a Gen12 伺服器:此款先前已發布的配置採用4U機型,最多可支援8顆NVIDIA RTX PRO 6000 GPU,並將於9月出貨。

HPE表示,HPE ProLiant Compute 伺服器專為處理多元工作負載與不斷增長的 GPU 加速運算需求打造。此伺服器為組織帶來靈活且高效的創新能力,進一步提升生產力、安全性與營運效率。HPE ProLiant Compute Gen12伺服器採用多層安全防護,包括搭載HPE Integrated Lights Out (iLO)7的矽根信任機制(Silicon Root of Trust),以及具備防竄改保護(tamper-resistant protection)與抗量子運算韌體簽章(quantum-resistant firmware signing)功能的安全隔離區(secure enclave)。

HPE表示,透過HPE Compute Ops Management提供的集中式雲端原生生命週期自動化,可減少IT團隊高達75%的伺服器管理時間,並每年降低每台伺服器4.8小時的停機時間。其目標工作負載包含生成式AI與代理型AI、實體AI(如機器人與工業應用)、視覺運算(如品管監控和自動駕駛)、模擬、3D建模、數位孿生及企業應用。

此外,HPE近期宣布新一代HPE Private Cloud AI將於年底前推出。該版本將支援搭載NVIDIA RTX PRO 6000 GPU的HPE ProLiant Compute Gen12伺服器、跨GPU世代的無縫擴充性、實體隔離(air-gapped)管理功能和企業多租戶(multi-tenancy)功能。

HPE Private Cloud AI 新增對 NVIDIA 最新推理模型與影片藍圖的支援。HPE Private Cloud AI是HPE與NVIDIA共同開發的一站式AI工廠解決方案,將支援最新版本的NVIDIA Nemotron模型以推動代理型AI、Cosmos Reason視覺語言模型(VLM)以實現實體AI和機器人應用,以及NVIDIA Blueprint for Video Search and Summarization(VSS 2.4),以建構能從海量影片資料中提取關鍵洞察的影片分析AI代理。

HPE與NVIDIA持續攜手合作,HPE Private Cloud AI 的獨特設計,能透過 HPE AI Essentials 為客戶提供最新 AI 模型與 NVIDIA Blueprints 所需的NVIDIA NIM微服務,實現快速部署。

HPE表示,藉由與NVIDIA AI加速運算、網路及軟體的深度整合,HPE Private Cloud AI讓企業能夠更快地發揮AI的全部潛力,同時保有對資料的控制。客戶可利用這套高效能解決方案,應對快速增長的 AI 推論需求,並加速 AI 產能。