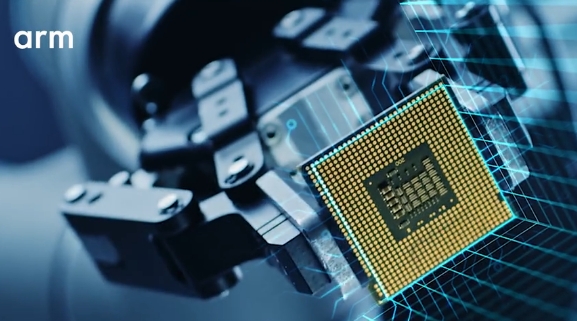

全球晶片矽智財(IP)大廠安謀(納斯達克上市代碼ARM),針對 2025 年及未來的技術發展做出以下預測,包括從 AI 的未來發展到晶片設計,到不同技術市場的主要趨勢。

以下是針對AI方面的預測:

AI 推論持續發展

在未來一年裡,AI 推論工作負載將繼續增加,這將有助於確保 AI 的廣泛應用和持久普及。這個趨勢的發展受惠於具備 AI 功能的裝置和服務數量的增加。事實上,大部分日常 AI 推論,如文本生成和摘要,都能在智慧手機和筆電上完成,為使用者提供了更快速、更安全的 AI 體驗。為了支援這項成長,此類裝置需要搭載能夠實現更快的處理速度、更低的延遲和高效率電源管理的技術。而 Armv9 架構的 SVE2 和 SME2 兩大關鍵特性,一起運行於 Arm CPU,使其能夠快速而高效率地執行 AI 工作負載。

邊緣 AI 嶄露頭角

全站首選:會晤習近平前先打伊朗 澳專家:川普暗藏精明的地緣政治戰略

2024 年,我們看到越來越多的 AI 工作負載在邊緣(也就是裝置端)運行,而不是在大型資料中心進行處理。這種轉變不僅能為企業節省電力和成本,還能為消費者帶來隱私和資安方面的保障。

到了2025 年,我們很可能會看到先進的混合 AI 架構,這些架構能夠將 AI 任務在邊緣裝置和雲端之間進行有效分配。在這些系統中,邊緣裝置上的 AI 演算法會先識別出重要的事件,然後雲端模型會介入,提供額外的資訊支援。決定在本地還是雲端執行 AI 工作負載,將取決於可用電源、對延遲的要求、隱私顧慮以及運算複雜性等考慮因素。

邊緣 AI 工作負載代表著 AI 去中心化的趨勢,使裝置能在資料來源附近實現更智慧、更快速且更安全的處理,這對於需要更高效能和因應在地決策的應用市場,如工業物聯網和智慧城市,尤其關鍵。

小語言模型(SLM)加速演進

隨著技術的進步,規模更小、結構更精簡、壓縮率更高、量化程度更高、參數更少的模型正在快速演進。典型的例子包括 Llama、Gemma 和 Phi3,這些模型不僅具備更高的成本效益和效率,也更容易在算力資源有限的裝置上部署。我們預計,2025 年這類模型的數量還將繼續增加。這類模型能夠直接在邊緣裝置上運行,不僅提升了效能,還能強化隱私保護。

我們預計,越來越多的 SLM 將用於裝置端的語言和裝置互動任務,以及基於視覺的任務,例如對於事件的解讀和掃描。未來,SLM 將從大模型中萃取出更多經驗和知識,以便開發本地專家系統。

能聽、能看、能理解更多內容的多模態湧現

目前,GPT-4 這樣的大語言模型(LLM)是基於人類文本進行訓練的。當這些模型被要求描述某個場景時,它們只會以文字形式回應。但我們也開始看到包含文本、圖像、音訊、感測器資料等多種訊息的多模態 AI 模型出現。這些多模態模型將透過能夠聽到聲音的音訊模型、能夠看到的視訊模型、以及能夠理解人與人之間、人與物體之間關係的互動模型,來執行更複雜的 AI 任務。這將賦予 AI 感知世界的能力,就像人類一樣,能聽、能看、能體驗。

AI 代理(AI agent)應用不斷拓展

如今,當使用者與 AI 互動時,通常是在與一個單一的 AI 進行互動,這個 AI 會盡可能獨立完成使用者要求的任務。然後,透過 AI 代理,在使用者指定需要完成的任務時,這個 AI 代理會將任務委託給由眾多 AI 代理或 AI 機器人組成的網路,類似 AI 的零工經濟。目前,客服支援和程式設計輔助等產業已開始使用 AI 代理。隨著 AI 的互聯性和智慧程度不斷提高,我們預計在未來一年,AI 代理將在更多產業快速發展。這將為下一個階段的 AI 革命奠定基礎,使我們的生活和工作變得更有效率。

AI 支援更強大、更直觀、更智慧的應用

在 AI 的推動下,裝置上將湧現更強大且個別化的應用。例如更智慧、更直觀的個人助理,甚至私人醫生。應用的功能將從簡單地回應使用者請求,轉變為根據使用者及其所處環境主動提供建議,實現 AI 的個人化。這將導致資料的使用、處理和儲存數量呈現指數級成長,因此業界和政府需要採取更嚴格的安全措施並提供監管指導。

醫療服務將成為關鍵的 AI 應用場景

醫療服務似乎已成為 AI 的主要應用場景之一,而這一趨勢將在 2025 年加速發展。AI 在醫療領域的應用場景包括:預測性醫療、數位記錄儲存、數位病理學、疫苗開發和基因療法等,以幫助治療疾病。2024 年,DeepMind 的創辦人因與科學家合作,利用 AI 預測複雜的蛋白質結構,且準確率高達 90%,被授予諾貝爾化學獎。同時,研究證明,使用 AI 可以將藥物研發週期縮短 50%。這些 AI 創新為社會帶來顯而易見的益處,加速救命藥物的研發和生產。此外,透過將行動裝置、感測器和 AI 相結合,使用者將能獲得更優質的健康相關資料,進而對個人健康做出更明智的決策。

推動實現「綠色 AI」

AI 將加速融入永續發展的實踐。除了使用高效率的技術,「綠色 AI」策略也將受到越來越多的重視。例如,為了因應日益成長的能源需求,AI 模型訓練可能會逐漸選擇在碳排放較低的地區和電網負荷較低的時間段進行,並可能成為未來的標準做法。透過平衡電網上的能源負載,這種方法將能緩解峰值需求壓力,減少總體碳排放量。因此,我們預計會有更多雲端服務提供者,推出針對效率優化的模型訓練的調度服務。

其他方法還包括:優化現有 AI 模型以提高執行效率,重複使用或重新定位預訓練的 AI 模型,以及採用「綠色編碼」,盡可能地減少能源消耗。在「綠色 AI」浪潮中,我們可能還會看到自發性標準的導入,隨後逐步形成正式標準,以促進 AI 的永續發展。

可再生能源與 AI 的融合發展

可再生能源與 AI 的結合,有望推動整個能源產業的創新。目前,可再生能源在可靠性和靈活性方面不足,難以平衡峰值負載,這對電網脫碳進程造成阻礙。我們預計,AI 將能夠更準確地預測能源需求,即時優化電網運行,並提高可再生能源的效率,進而幫助解決這些問題。電能儲存解決方案也將受惠於 AI,AI 能夠優化電池效能和壽命,這對於平衡可再生能源的間歇性特性至關重要。

導入 AI 不僅有助於解決預測和平衡峰值需求的難題,還能預測與識別維護需求,進而減少能源供應中斷。智慧電網則可利用 AI 進行即時電能流動的即時管理,有效降低能源損耗。AI 與可再生能源的深度融合,預計將可大幅度地提高能源系統的效率和永續性。

異質運算滿足多樣化 AI 需求

在廣泛的 AI 應用中,尤其是在物聯網領域,不同的 AI 需求將需要多種運算引擎。為了最大化部署 AI 工作負載,CPU 將繼續成為現有裝置部署的關鍵。新的物聯網裝置將搭載更大的記憶體和更高效能的 Cortex-A CPU,以強化其 AI 效能。而新推出的 Ethos-U NPU 等嵌入式加速器,將被應用於加速低功耗機器學習(ML)任務,並為工業機器視覺和消費性機器人等更廣泛的應用場景提供高效率的邊緣推論能力。

從本質上來看,在短期內,我們將看到多個運算元件被應用於滿足特定 AI 應用的需求。這種趨勢將持續彰顯開發通用工具、軟體技術庫和框架的必要性,以便應用開發人員能夠充分利用底層硬體的功能。邊緣 AI 工作負載並不存在「萬能」的解決方案,因此,為生態系提供靈活的運算平台非常重要。