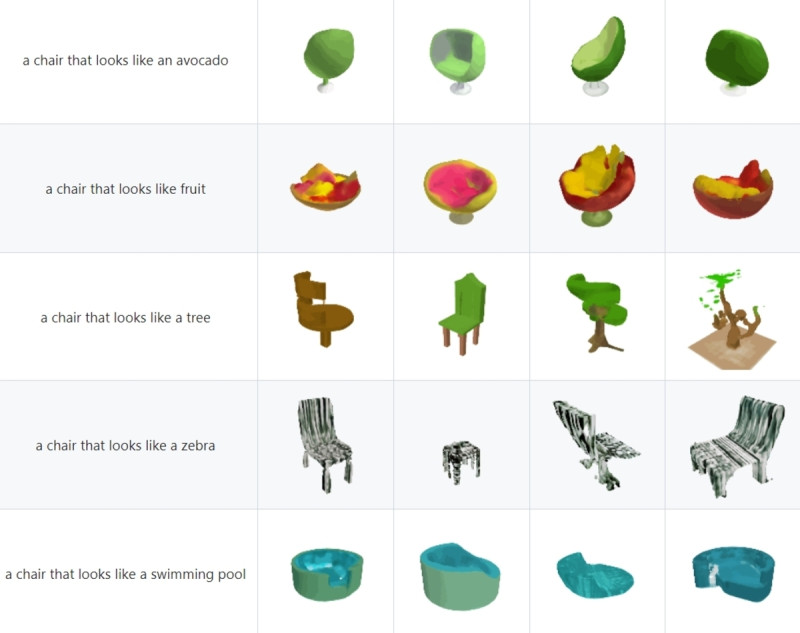

OpenAI去年發表的「Point-E」是據文字提示產生3D點狀雲,而在昨(8)日新發表一款,可以將文字或圖片轉成3D圖形的「Shap-E」模型,可在GitHub下載。成果可以在微軟小畫家3D(Paint 3D)中開啟,甚至能夠轉成用於3D列印機輸出的STL檔案。此外,Shap-E 相較去年發表的Point-E,能夠提供更好的3D圖形,產出效率更高。

今年OpenAI開發的「Shap-E」3D模型,是直接建立出物體的輪廓,並採用神經輻射場(Neural Radiance Fields,NeRF)的功能,克服了初期模型的模糊性。NeRF與 VR、AR使用的技術相同,可使3D場景視覺上更有臨場真實。Shap-E 可在GitHub下載,並能在個人電腦上安裝執行,目前Shap-E也不需要OpenAI API密鑰,能夠免費使用。

現正最夯:柯文哲228籲「別一直停留在悲情」 吳靜怡:為了蹭藍踐踏家屬長痛

據外媒《Tom’s Hardware》測試, Shap-E無論是要利用圖片還是文字都需要大量的電腦系統資源。Tom’s Hardware 指出,例如以搭載RTX 3080顯卡和Ryzen 9 5900X處理器的桌機跑Shap-E,完成繪製大約需要5分鐘。

而在ROG電競筆電配備RTX 4090顯卡和Intel Core i9-13980HX處理,只需要兩到三分鐘。 但當嘗試在搭載 Intel 第 8 代 U 系列處理器結合內建顯卡的舊款筆電跑 Shap-E,1 個小時只繪製約 3%。此外 Shap-E 不支援NVIDIA以外的顯卡品牌,硬體規格需要達到一定程度,才不會耗費許多等待時間。整體而言,目前Shap-E的成果多數仍是低解析度,缺少細節。

目前Shap-E的成果多數仍是低解析度,缺少細節。 圖:取自GitHub