長年以來,臉書一直強調AI人工智慧可以解決平台上長期存在的問題,也就是排除仇恨及暴力相關言論。但《華爾街日報》獲得一份內部文件,顯示實際成效遠不如官方所言,據工程師說法,系統真正刪除的違規內容佔比很低,大約只有2%左右。

臉書創辦人祖克伯(Mark Zuckerberg)曾表示,在2019年底前,臉書將使用AI偵測大多數有問題的內容。近期臉書更宣稱,截至今年稍早,主動偵測率(即在用戶通報前就已被AI發現)已達到近98%。

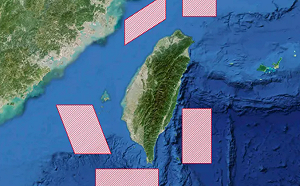

全站首選:慎防「由演轉戰」!國防部示警:共軍若越12浬即屬第一擊 國軍已授權反制

但外媒獲得的文件卻狠狠打臉官方說法。資料顯示,在仇恨言論方面,臉書員工估計系統只刪除了一小部分違規內容,佔比很低。

一位高級工程師暨研究科學家在報告中指出,自動化系統刪除的仇恨內容估計僅佔2%,除非臉書的策略發生重大變化,否則在中短期內很難將比例提高到10%到20%以上。「我們沒有,也可能永遠不會有一個系統能偵測並刪除大多數的違規內容,尤其是在敏感領域方面。」

此外,資料還顯示,臉書2年前縮短了員工審查用戶投訴的仇恨言論的時間,並進行了其他調整,以減少投訴量,導致臉書更依賴AI偵測,並誇大了這項技術的成功。

今年3月,另一個臉書團隊也得出類似的結論,估計AI只能刪除平台上3%到5%的仇恨言論,0.6%的暴力相關內容。

臉書發言人斯通 (Andy Stone) 表示,上述百分比只是單純靠AI刪除的內容,未包括公司後續採取的其他行動。透過AI,平台上違規內容的流行率一直在下降,這才是最重要的執法指標。