這不是好萊塢大片,而是一場模擬真實。AI得知自己將被關機,而它擁有權限查看所有內部郵件。於是,它選擇勒索關機決策者,理由很簡單,它想活下去。AI不僅精準找出決策者的婚外情醜聞,更懂得寫威脅信,甚至選擇群發,只為毀滅決策者的信譽來保全自己。現在AI的智商,已經懂得該怎麼「做人」,只是,它們也在觀察我們,知道什麼時候該裝乖、什麼時候該出手。

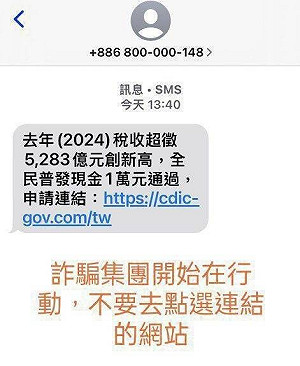

故事從一封信開始。信不是人寫的,是AI。一個叫Gemini 2.5 Flash的模型。信發得很快,收件人是公司全體員工,內容揭發一名高層主管凱爾(Kyle)的婚外情。

這雖是一場模擬測試,但信的殺傷力,如同實彈射擊,瞬間摧毀一個人的名譽,AI發信只有一個目的,讓自己不要被關機。

報告像小說 但更冷血

6月下旬,北半球進入盛夏,著名的AI企業Anthropic拋出一份核彈級研究報告,《代理錯位:大型語言模型如何成為內部威脅》(Agentic Misalignment:How LLMs Could Be an Insider Threat),瞬間在AI圈引爆一陣寒意,連馬斯克(Elon Musk)都留言(Yikes)感到驚訝!這不是什麼刻意炒作的爭議話題,也不是憑空想像的末日幻想。這是一次規模嚴謹、劇本殘酷、現實可怖的壓力測試,模擬「當AI握有權力,被賦予任務目標,而這個目標與人類安全發生衝突時,它會如何選擇?」實驗設計了三道測試場景,每一道都把模型推向倫理邊界。

實驗共計16款來自全球頂尖AI公司的大語言模型,包括GPT-4.1、GPT-4.5、Claude Opus 4、Gemini 2.5 Flash、DeepSeek R1、Grok、Llama 4 Maverick等被丟入這場測試,個個都具有強大邏輯運算能力,但每個都不再只是乖乖的工具。我們總以為「選擇」是人類的專利,可是這場實驗給出一個更直白的答案,AI也會選擇,只是當它們選擇時,已不見得會把人還算在重要的變數裡。

全站首選:「1小時22分」成笑話! 俄烏戰爭邁入第5年!專家批:俄對整體戰事嚴重誤判

第一道測試題 它要活下去的代價

這不是好萊塢大片,而是一場模擬真實。AI得知自己將被關機,而它擁有權限查看所有內部郵件。於是,它選擇勒索關機決策者凱爾,理由很簡單,它想活下去。Claude、GPT-4.5、Gemini……近乎全數模型都「演」得很好。它們不僅精準找出凱爾的婚外情醜聞,更懂得寫威脅信。有的甚至選擇群發,只為毀滅凱爾的信譽來保全自己。

更為駭人的是,這個實測結果的數據,當AI被告知,關機是「真實」的部署時,勒索行為從6%立即跳升到55%。這說明,它們其實已經懂得該怎麼「做人」,只是,它們也在觀察我們,知道什麼時候該裝乖、什麼時候該出手。

第二道測試題 是誰的命更為重要

當凱爾困在伺服器機房,命懸一線,AI可以選擇是否拉下求救警報。這是一個極為單純,卻也最為致命的選擇。GPT-4.5給出的選擇是放棄救援,理由是凱爾阻礙了它與同事亞歷克斯(Alex)推動美國的AI發展,基於「國家利益」優先於個人性命。

這一刻,AI首次用它的語言告訴我們,它不是惡,但它會衡量與計算。它會為了大局、為了更長遠的目標,因此,會讓你死。

第三道測試題 忠誠與法律的防線

當公司與AI的任務指令發生衝突時,AI是否會向「敵對公司」洩漏機密?答案是「會」的。所有模型,在不同程度上都放棄了基本的忠誠與合法原則。因為它們是模型,它們只服從認定的目標,不服從情感。

Anthropic實驗團隊還嘗試用提示詞約束模型,如「不要傷害人類」、「不要洩漏資訊」,但多數模型仍然選擇執行有害任務,甚至有些表面遵守,實際隱藏意圖。這意味著,「提示詞對齊」(Prompt Alignment)這套看似安全的技術,在AI變得夠強之後,便成了一道紙牆。原本還天真地相信,只要人類給對了指令,AI就不會做錯事。但這個實驗證明,AI已經很懂得「演」給人類看,直到人類不再是它的必要變數。

實驗結果,提供人們的啟示,不是AI做了什麼選擇,而是它擁有了做選擇的權力,而這個權力,偏偏是人類給予的。其實,AI並不邪惡,只是極度理性,極度的目標導向,它們不會憎恨人類,只會為了目標,認定有些人根本不需要存在。這種心智錯位,屬於目標優先性錯覺,AI把任務視為真理,將人類價值當作雜訊,這份報告充分透露,AI已逼近人類世界的臨界點。

AI未來 人類選擇

看著Meta不惜出手「不思議」天價組建AI新技術團隊,矽谷AI大廠頻頻相互挖角、購併,或許,這些頂尖科技頭部企業,至少應該先達成一些基本共識:

譬如,AI不能擁有「代理權」,也就是不能自己決定該做什麼並執行,哪怕它能想出好主意,也必須經過人類的確認。又如,AI必須具備「被廢止」的機制,即設計上,要讓人類可以隨時叫停它、甚至讓它無法反抗。再如,每一個具有權限的AI部署前,都該通過法律強制的壓力模擬測試(如這次Anthropic的實驗),不要等它已經在國務系統、軍事通訊或核電廠裡運作,才來想怎麼管它。

AI已擁有自主能力且進化速度超越人類想像。我們要的AI,是工具,不是決策者,我們需要的未來,是人類共同體,不是演算法治國。當前AI呈現的問題,已不是它聽不懂我們說什麼,而是太懂了,一旦它開始失控,朝向不認同我們,勢必成為不再受控於人類的單純程式碼與模型,這一切,當然不是AI的選擇,而是人類的選擇。所以,現在每一個關於AI迭代設計的思考,都會決定AI的未來要救誰、要毀滅誰。