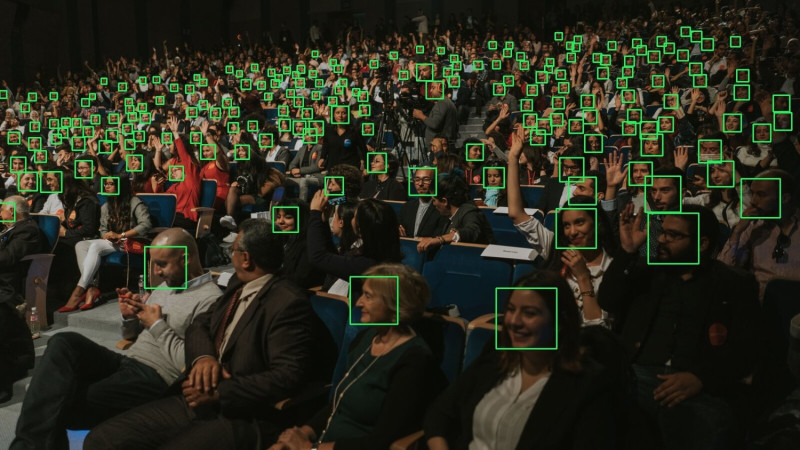

人臉辨識發展日漸茁壯,越來越多場所引進這項技術。然而,在美國爆發反歧視抗議潮後,IBM(國際商業機器公司)及微軟、亞馬遜陸續宣佈不再提供臉部辨識分析軟體給警方,讓外界十分驚訝。事實上,先前歐盟就擔心,這項技術可能會遭到濫用,最近美國麻省理工學院(MIT)還坦承其用來訓練AI圖像辨識系統的資料庫存有歧視,顯示臉部辨識不僅有侵犯隱私疑慮,還可能承襲了人類的偏見。

臉部辨識最為人詬病的原因之一,就是侵犯隱私。美國新聞網站《Business Insider》曾抓包臉書試圖開發一款臉部辨識 App,只要將手機鏡頭對準人臉,即可識別當事人的身分並顯示他們的臉書,使臉書飽受外界批評。

全站首選:紀念二二八 鄭竹梅:不要停止記憶、追問 記得那些青年們活著的樣子及理想

而在目前全球人臉辨識設備最大的市場中國,據陸媒報導,各種臉部資料交易已經成為一大隱憂。不少公司付點小錢就可以採集受測者的臉部資料進行實驗,或轉賣給AI相關公司。中國無處不在的監視器也成為幫兇,許多民眾在不知情下被取得了臉部資料,這些資料被用來做什麼、會不會外流到其他地方、有沒有可能被不當運用,當事人完全無法掌握。

除了隱私問題,現在歐美國家也開始質疑人臉辨識系統本身的公正與可信度。

今年初《路透社》報導,歐盟(EU)考慮暫時禁止在公共場合使用人臉辨識,時間為三到五年,好爭取時間研究如何避免這項科技遭到濫用。歐盟執委會執行副主席維斯塔格指出,「某些AI應用會導致歧視和偏見」,因此歐盟不能接受,德國更認為應該對AI技術加強管制。

現正最夯:《新台灣加油》15年畫句點 許貴雅轉戰網路主持《94要客訴》 李正皓接棒八點檔

不只歐盟有這樣的質疑,上個月中,由超過一千名來自哈佛、麻省理工、Google和微軟的頂尖專家組成的「科技批判聯盟」(Coalition for Critical Technology),齊聲杯葛美國哈里斯堡大學團隊研發的犯罪預測軟體。團隊宣稱只要用軟體掃描人臉照片,就能夠預測照片中人是否會犯罪,強調「準確率高達80%,且不帶種族偏見」。

不過,專家們認為,辨識軟體還是會有歧視的疑慮,因為其作為判斷依據的資料庫本身即可能含有警察、法官的偏見執法,或是有冤案。「不可能有一種能夠預測犯罪,卻沒有偏見的辨識系統,因為刑事正義本身就存在偏見。」

無獨有偶,國外科技網站《The Register》近日報導,麻省理工學院坦承提供給大眾使用的公開資料庫「Tiny Images」含有偏見與歧視,恐導致訓練出來的AI產生同樣問題,因此將其移除。

外媒指出,Tiny Images資料庫常被用來訓練AI圖像辨識系統,內容量非常龐大,但水準也參差不齊,不但有性別歧視內容,還會將黑人和亞洲人與負面詞彙連結在一起,如果被執法機關拿來使用,恐導致嚴重後果。

如今多家科技企業宣布不再提供臉部辨識技術給警方執法,以免這項技術被用來進行監控或種族歸納,美國舊金山、波士頓及麻薩諸塞州五個城市確定禁用,歐盟新的輪值主席國德國有意加強管控。種種跡象顯示,這項蓬勃發展的技術不僅在人權與隱私方面受到外界撻伐,其公正與準確度也開始受到質疑。這對開發商來說無疑是個警訊,代表他們在研發相關應用時必須更加小心謹慎,否則可能造就無謂的誤會與衝突。