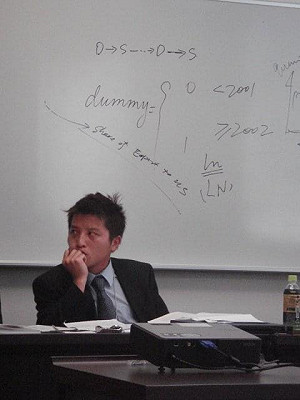

軟銀集團旗下的半導體設計與軟體公司安謀控股(Arm) 終端產品事業部產品管理副總經理 James McNiven昨天(21日) COMPUTEX Forum 2025發表演講,點出AI未來關鍵需求,以下是演講的重點內容:

一、AI 無所不在

當前熱搜:新北鶯歌鳳鳴平交道驚傳死亡意外 台鐵南下列車出現大誤點

AI 為我們帶來世代難逢的機會。在過去兩年內,模型變得更聰明、更精準 - 具備推論能力、支援多模態運算、可處理更長的上下文。裝置端與邊緣 AI 已經成真,AI 代理正在出現,而實體 AI 也逐漸浮現,使 AI 能夠與真實世界互動,包括感測數據的輸入。

雖然 AI 在近兩年才迅速崛起,但所謂「隱形 AI」早已存在多年 - 提升視訊會議品質、臉部辨識、音樂辨識等。許多人仍對 AI 半信半疑,其實他們未必意識到,AI 已深刻影響他們的生活,且具備未來發展潛力。

二、AI 改變數十億人的生活 但正面臨現實的嚴峻挑戰

AI 可將新藥研發週期縮短多達 50%、加速自駕車技術發展、協助發展氣候變遷對策、提升各產業流程效率。

但 AI 所需的電力需求驚人,像 ChatGPT 這樣的模型耗電量是傳統搜尋的 15 倍,AI 資料中心的用電量相當於 10 萬個家庭的用量。若不妥善控制,AI 的電力消耗將呈指數級成長,恐將超過地球可提供的總電力資源。我們必須重新思考裝置的設計方式,確保它們兼具效率及效能。

三、Arm 是雲端運算的核心

Arm 的設計考量始終優先關注能源效率與強大運算,這也是為什麼從 AWS 到阿里巴巴等各主要超大規模資料中心業者(hyperscalers)都已採用 Arm 技術。

起初,這些業者的伺服器主要執行第一方工作負載。後來第三方需求興起,促使軟體最佳化需求上升。Arm 提供高可攜性、易於使用與創新,同時帶來 40% 更高的能源效率。

客製化晶片已證明是推動 AI 系統創新、效能與效率的基石。Arm 在此領域的發展態勢迅速 - 在 2025 年,近 50% 新出貨給超大規模資料中心的伺服器晶片將採用 Arm 架構。

四、AI 推論將朝向邊緣端轉移

汽車安全、消費性電子與物聯網製造等應用,驅動推論朝向邊緣端轉移,這些應用領域對於延遲、效率與隱私的要求極為重視。約 50% AI 推論現已在消費性裝置上進行,在車用系統中,這個比例接近 100%。我們預計這個趨勢將持續成長,強化了從雲端到邊緣端對大量運算的需求。

裝置端 AI 可即時提供結果,支援擴增實境、自駕車與醫療診斷等即時應用。透過將運算負擔移轉到本地裝置,使大規模部署更具成本效益,並確保 AI 在連接受限的區域的可用性,進而降低了雲端基礎設施的成本。

除了技術優勢外,邊緣 AI 還可促進 AI 普及化,使全球開發人員在不需要大量資源或基礎設施的情況下,能針對在地需求開發創新 AI 工具。

五、AI 模型創新釋放邊緣推論潛能

透過更小、更快、更具效率的模型推出,AI 模型創新將加速邊緣推論的潛力。像 Phi-2 和 TinyLLaMA 等輕量架構已可在手機和其他邊緣裝置上完整執行,稀疏與模組化設計則降低運算與電力消耗。

高效記憶體/token 使用、指令調校與量化感知訓練等技巧,讓模型在有限資源中也能順暢運行,並維持效能。

訓練、量化與壓縮技術也是推動邊緣 AI 擴展的關鍵。轉移學習與指令調校加速模型對跨裝置的適應,4-bit 與 8-bit 量化讓大語言模型能在小於 4GB RAM 的裝置上執行。壓縮與蒸餾技術能進一步縮小模型體積,而最佳化推論則可實現低延遲、低功耗的即時效能,即使是在資源受限的硬體上也是如此。

六、Arm 平台每天都催生出嶄新的 AI 應用場景

新興邊緣應用正在改變裝置型態 - 穿戴裝置已成為協助認知的輔具,強化視覺/聽覺體驗,並支援裝置端的智慧助理。AI 代理可依據即時環境(如地點與影像)簡化多步驟的複雜任務。

在工業領域,邊緣 AI 透過及早偵測車輛、機器人與設備的異常等方式,協助預測性維護。Arm 持續聚焦安全性、效能與功耗,不斷創新,使開發人員能夠從最新的工具中受惠,使邊緣裝置同時能支援 AI 專用與一般通用的工作負載。

最佳化運算與記憶體資源、處理模型大小限制與功耗挑戰、以及確保個人資料在邊緣裝置的安全性,仍是重要課題。

七、Arm 異質 AI 運算平台願景

CPU 是所有裝置不可或缺的核心,但 AI 運算不僅是 CPU 的任務 - 關鍵在於透過異質平台的分工協作,為 AI 任務提供最適合的運算資源。異質化設計已成主流 - 結合 CPU、GPU 與 NPU,以最佳化 AI 在各類工作負載下的效能表現。

NPU 適用於特定任務,如 OEM 所需的運算成像等,但通常需配合專門的工具進行量化與運算操作支援。

Arm CPU(特別是具備 Armv9 強化功能的版本)是最被廣泛部署、被第三方開發人員存取最多、且相容性最高的技術平台。

Arm Mali GPU 增加 AI 的彈性,可高效率支援多種 AI 框架,減少開發人員須進行深入調整的負擔。進一步提升的關鍵在於持續最佳化處理器設計,並導入如 SME 等強大新功能。

八、持續架構創新 為帶來 AI 效能帶來質變

Arm 持續在每一代 CPU 提升 AI 效能與效率。自 Armv9 起,我們持續推出包括 SVE2 在內的強化功能,現已應用在例如聯發科技天璣 9400 等旗艦平台。

展望未來,我們最新的架構創新 - 可擴展矩陣延伸指令集(Scalable Matrix Extension,SME)技術,正是為次世代 AI 工作負載量身打造,透過通用指令集帶來卓越效能與效率,簡化跨生態系的開發與部署。

SME 是一項強大的擴充指令集,可加速核心 AI、機器學習(ML)與高效能運算(HPC)工作負載,其創新之處包括可高吞吐量處理的串流 SVE 模式、外積指令、專屬 ZA(Z 陣列)儲存空間,用於高效矩陣運算。

它支援多種資料型態與 128 至 2048 位元的可變向量長度,使不同裝置等級皆可擁有可擴展效能,並持續推進 AI 模型的創新。

SME2 在此基礎上新增多向量指令與強化 ZA 使用率,提升並行運算與整體效能。其支援即時去量化 2-bit 和 4-bit 權重,使其極適合生成式 AI。

在結合 Kleidi(Arm 最佳化的 AI 與電腦視覺的軟體核心)後,開發人員將獲得一個高效能、靈活的平台,驅動次世代邊緣 AI。

九、超過 2200 萬名開發者在 Arm 平台開拓創新

超過 2200 萬名開發人員投入 Arm 生態系,形成一個強大的正向循環 - 每一位開發人員都為 Arm 硬體創造更多價值,驅動整體生態系朝向更繁榮的發展態勢。

Arm 致力為開發人員打造一個無縫開發的環境,確保軟體「立即可用」,降低開發複雜度,讓他們能專注於打造 AI 應用。Kleidi 正是依此理念發展而來的最佳例證。它已整合至所有主流 AI 框架與業務領域,讓 Llama、Mediapipe、混元等頂尖 AI 模型能在 Arm CPU 上快速運行 - 有時甚至在新模型發布後 24 小時內就能執行。

Kleidi 正是依此理念發展而來的最佳例證。它已整合至所有主流 AI 框架與業務領域,讓 Llama、Mediapipe、混元等頂尖 AI 模型能在 Arm CPU 上快速運行 - 有時甚至在新模型發布後 24 小時內就能執行。

Kleidi 抽象化了底層硬體複雜性,讓開發人員無需微調即可獲得極致效能,支援從雲端到邊緣的各式平台,如 PyTorch 與 ExecuTorch。

Kleidi 完整支援 SME,並持續地針對未來技術發展進行最佳化,協助開發人員輕鬆擴展 AI 工作負載至 Arm 平台。

十、實現 AI 普及化勢在必行

AI 擁有巨大潛能,但其對運算與記憶體的高度需求,帶來了昂貴的成本,也造成普及上的障礙。Arm 正透過橫跨 CPU、GPU、NPU 與更多處理單元的高能源效率的運算平台,讓 AI 從雲端普及至邊緣。

能源效率的提升必須涵蓋所有級別的裝置 - 不應只針對高價的旗艦手機,人人都應享有 AI 帶來的便利與創新。這也是 Arm 推廣 AI 規模化的重點,AI 必須能跨應用市場在不同等級的裝置上實現。

因行動裝置的普及性,使其成為推進 AI 規模化的關鍵平台 - 是推動 AI 擴展至整個邊緣生態系的起點。

但真正的 AI 進展,不只是更智慧的硬體或模型,而是我們是否能用「更聰明」的方式來擴展它們。讓我們一起攜手,建構一個強大、高效率且公平的 AI 生態系 - 讓 AI 為每個人而生。