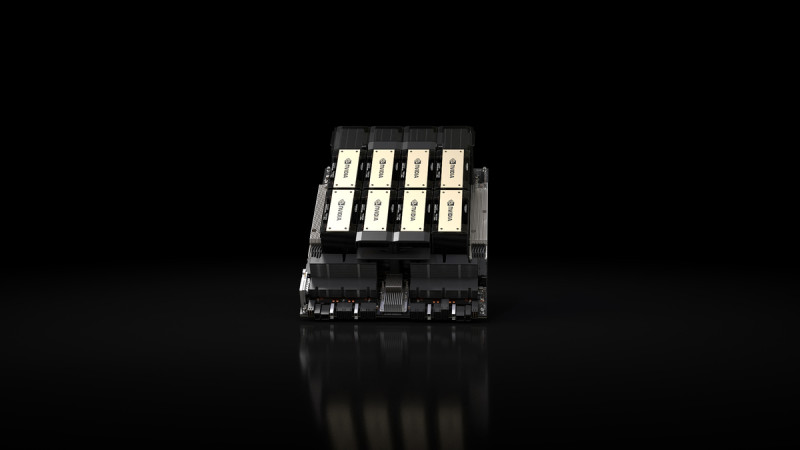

輝達(Nvidia)13日宣布,推出了升級版的旗艦AI晶片- H200,新晶片H200採用了高頻寬記憶體(HBM3e),不但比前可支援更強大的人工智慧系統。能夠加速處理大型的AI資料集,如亞馬遜、Google、微軟、甲骨文等美國科技巨頭均表示將搶先採用這款新晶片。

輝達的H100處理器是一款專為AI運算而設計的高效能晶片,該產品受到市場的熱烈追捧,並為OpenAI的ChatGPT以及許多其他的生成式人工智慧服務提供支援。但也面臨著來自其他廠商的挑戰,例如超微(AMD)的MI300晶片和英特爾的Gaudi 2晶片,這些產品都宣稱能與H100匹敵或超越。為了保持在AI領域的領先優勢,輝達對H100進行了技術升級—推出新的H200晶片,並提升了其運算速度和效能。

全站首選:卓揆下令:政院各部會任何資料都不提供李貞秀 也不接受質詢

H200晶片,能夠支援創造的AI模型和服務的資料集的規模與速度,同時提升了存儲能力,擁有更高頻寬的記憶體,H200晶片裡擁有141GB的高頻寬記憶體,較H100的80 GB大幅提高,讓H200在訓練AI進行圖像和語音等任務的識別過程中更加迅速,也讓人工智慧服務可以更快給出答案。因此,亞馬遜的AWS、Alphabet的Google Cloud,Microsoft Azure以及甲骨文的雲端基礎設施(Cloud Infrastructure)等美國科技巨頭都已經表示,將在明年開始採用這款新晶片。