6月底,Open AI宣布,他們已經在Valve的熱門MOBA遊戲《DOTA 2》中5V5團體戰擊敗業餘人類玩家,8月底將挑戰世界第一頂級戰隊。Open AI最新消息表示,AI學習玩遊戲,只需要看人類玩家做過一次,就可以自己學習出最高分的最高解,不需要大量樣本。

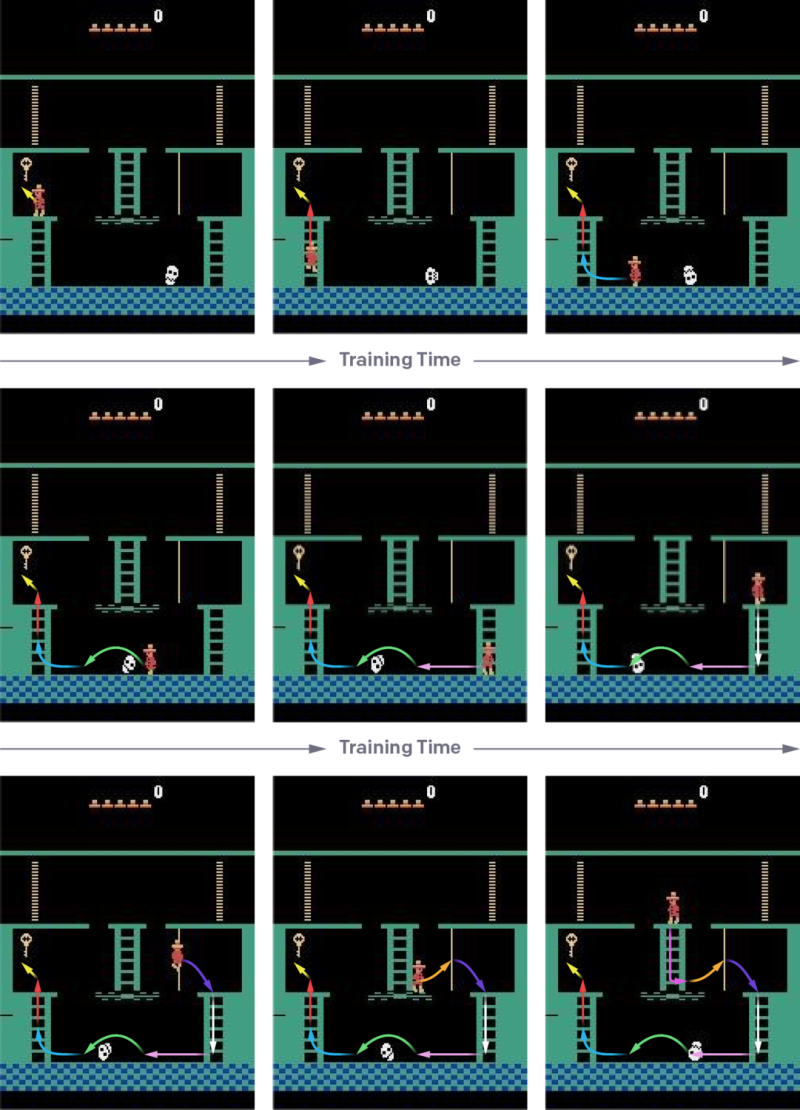

在Open AI最新的Blog中,他們讓Open AI玩《蒙特蘇馬的復仇(Montezuma’s Revenge)》這款遊戲,這是一款1984年的平台動作遊戲。結果透過機器學習,AI得到了74,500分的高分紀錄,是所有公開紀錄中最高分;研究人員只示範了1次,AI不是單純試圖模仿人類玩家,而是透過獎勵去對取得高分的行為做最佳化。

現正最夯:對伊開戰 「野鼬鼠」當先鋒? 川普才嗆派第二航母戰鬥群 美再調6架F-35赴英

要做到這個自我學習成長的結果,Open AI先是挑選了一段適當的人類遊玩片段,然後讓AI接在這個片段之後遊玩。如果AI能在至少20%的剩餘的遊戲部分中得分與人類玩家平手或是超越,即視為「擊敗人類玩家」,然後將AI的學習起始點再往前推。舉例來說,一款遊玩時間為14分鐘的遊戲,人類玩家示範00:00~13:30分段之間的遊戲,之後讓AI接手。如果AI能夠「擊敗」玩家的話,下次就讓AI從13:20開始進行遊戲,以此類推直到遊戲全部由AI得勝。

這樣的方式,是為了解決探索的問題。由於《蒙特蘇馬的復仇》是一款充滿跳躍、怪物、平台、寶物等要素的遊戲,對AI來說解決問題的原因非常複雜。Open AI表示,讓AI從一開始隨機探索,並獎勵有益事件出現的機制在這種遊戲中根本不可行,這是因為,AI要隨機到一個「完整通關且得高分」的序列猶如海底撈針。與之相反,Open AI的方式將整個遊戲切成數個短序列的方式,有如讓AI「記得」之前的遊戲該怎麼玩才是最好的,並且獎勵找出更好、更有效率的方法。

Open AI認為,他們與Google DeepMind最大不同就在於,DeepMind使用模仿學習法,它是讓AI去模仿人類示範組中展示的最佳解法,而不用去對執行環境進行控制,不需要特別設置遊戲的狀態,而且不會假設代理人會遭遇到人類示範中的所有遊戲狀態。但這樣的方式,讓AI頂多達到跟人類示範者一樣的遊戲水準。而Open AI的方式,允許AI去思考人類玩家沒有思考過的過關方式,因此可以獲得可能的更高分。

當前熱搜:高金素梅涉3案遭搜!他揭「清算」目標:現任縣市長與立委危險了

延伸閱讀: