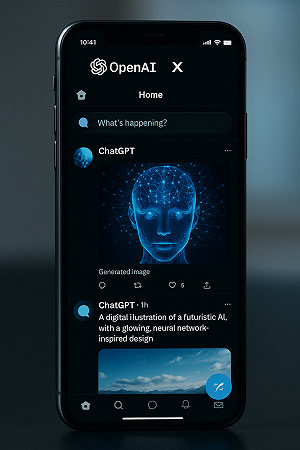

隨著人工智慧工具如ChatGPT廣泛進入日常使用場景,專家提醒,部分內容若不加篩選就輸入AI,恐對個資與企業安全帶來風險,包括身分資料、帳號密碼、醫療紀錄等,皆可能在未經使用者掌控下被處理與保存。

「當你把東西輸入AI,就不是你的了。」史丹佛大學人本人工智慧研究中心(HAI)研究員珍妮佛(Jennifer King)向《華爾街日報》直言,一旦資料交由聊天機器人處理,用戶即喪失對其掌控權。以下5類資料類型,被珍妮佛點名最不應直接交由AI處理:

1) 涉及公司運作的內部內容:

許多人在工作中使用AI協助撰寫簡報或郵件,可能未察覺輸入內容涉及尚未公開的專案、客戶名單或內部作業細節。這些資料若無適當保護,極可能於處理過程中暴露於風險之中。

2) 含有個資的醫療報告:

醫療機構依法保障病患隱私,但AI並不納入相關法律規範內。若直接上傳完整的檢查報告,可能包含姓名、病歷號碼等識別資訊。專家建議應先進行去識別化處理,只留下必要數據項目。

全站首選:2,000萬大獎已刮出兩張!2026金馬年刮刮樂攻略 拚頭獎選哪張? 賺錢率最高的是誰?

3) 各類帳密組合資訊:

部分使用者將平台帳號或密碼資訊交由AI保存或處理,但AI系統缺乏密碼工具所具備的加密與隔離機制,一旦遭存取或外洩,將造成帳戶風險。應改用專業的密碼管理服務並搭配多重驗證。

4) 可識別個人的基本資料:

如生日、電話、住址、證件號碼等,一旦輸入AI系統,將可能被記錄或作為演算法訓練素材。OpenAI指出,他們致力於避免蒐集個人資訊,但更安全的作法仍是避免輸入。

5) 與金融操作有關的帳戶資訊:

包含銀行、投資或付款工具的帳號資訊,若交由AI處理,將面臨被駭客攔截或用於非法活動的可能性。專家建議,這類資料應完全排除在與AI互動之外。

除OpenAI外,Google的AI系統Gemini亦在官方頁面公開提醒,使用者不應輸入任何可能被審查的機密資料。人工智慧公司Anthropic執行長Jason Clinton則建議,使用AI後應立即清除對話記錄,並啟用高強度密碼與兩步驟驗證等安全設定。

儘管部分平台聲稱會在30天內自動刪除使用資料,專家認為,AI如何使用這些輸入內容仍缺乏外部審核與技術監督。對企業與高度重視隱私的使用者而言,選擇何種內容與AI互動,仍須小心謹慎。