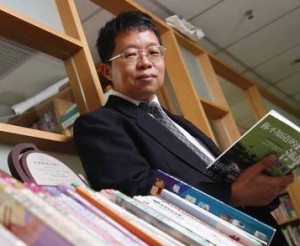

我國中研院資訊科學研究所研究員王新民、資訊科技創新研究中心助研究員楊奕軒、林彥宇所領導之研究團隊,獲得美國電腦協會國際多媒體年度學術研討年會(ACM Multimedia 2012)所頒發的「電腦多媒體應用頂尖挑戰」(Multimedia Grand Challenge)首獎。

現正最夯:18公分變12.5?男子控泌尿醫師害他縮水!提供照片遭法官「這句話」打槍

ACM Multimedia 2012是目前全球多媒體研究最重要的學術交流平台,「電腦多媒體應用頂尖挑戰」則是其中最受重視的一項競賽活動。今年,中研院研究團隊以名為「自動化音樂影帶生成之聲學視覺情緒高斯模型」(Acousticvisual Emotion Guassians Model for Automatic Generation of Music Video)的機器學習演算法奪冠。這項演算法的特點,在於使用聲音、視覺、情緒來自動分析及辨認多媒體影音的「情緒內涵」。

「電腦多媒體應用頂尖挑戰」自2009年起,為使多媒體研究更切合業界需求,每年研討會期間,由幾家國際上最具影響力之多媒體公司提出未來3~5年最重要、最前瞻的困難議題及需求,開放學術界競逐以尋求最佳解決方案。今年由Google、3DLife、HP、NHK、NTT以及Technicolor六家國際大企業提出六項挑戰。提出的議題包含自動化音樂影帶生成與配對系統(Google)、線上虛擬實境與互動(3Dlife)、影像與錄相情緒衝擊感知(HP)、自動化美感評估影像擷取(NHK)、社群媒體之圖文事件辨識(NTT)以及特殊事件之影音辨識(Technicolor)。

此次參賽,是由本院資訊所研究助理王如江、卓奕宏、研究員王新民以及資創中心助研究員楊奕軒與林彥宇共同組成的團隊以一套新穎且有效的機器學習演算法──「聲學視覺情緒高斯模型」(Acousticvisual Emotion Guassians Model)參與由Google所提出的「自動化音樂影帶生成與配對系統」(Automatic Music Video Generation Challenge)競賽議題,與來自中國大陸、新加坡、美國、法國、荷蘭及香港等國的17支優秀的決賽團隊競逐,終脫穎而出榮獲首獎。

中研院以聲學視覺情緒高斯模型來自動分析及辨認多媒體的情緒內涵;在聽覺方面是透過音色、音調與節奏等特徵,而視覺方面則透過色彩、亮度與畫面跳動頻率等特徵,來分別辨析影片及音樂的情緒內涵,進而以情緒為根基進行兩者的自動配對。這套系統,亦可支援使用者以音樂搜尋具有相關情緒的影片。這項技術,可應用於個人影片的聲音後製,或是諸如YouTube等社群影像分享網站上;也可自動為音樂錄影帶製作人推薦適合搭配的影片,讓使用者輕鬆完成影音俱佳的多媒體作品,具有很高的娛樂以及應用性。