陸媒《鈦媒體App》 今 ( 14 ) 日報導,輝達近日發表新一代 AI 晶片 H200,旨在培訓和部署各種人工智慧模型。針對中國市場,14 日達在郵件中向《鈦媒體App》確認:如果沒有獲得出口許可證,H200 無法在中國市場銷售。

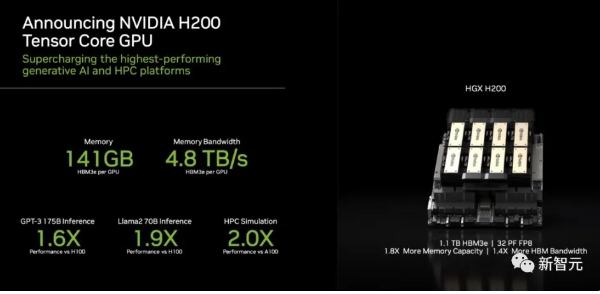

輝達在深夜發布目前世界最強的 AI 晶片 H200,較前任霸主 H100,H200 的性能直接提升了60% 到 90%。

不僅如此,這兩款晶片還是互為相容的。這意味著,使用 H100 訓練/推理模型的企業,可以無縫更換成最新的 H200。

全世界的 AI 公司都陷入算力荒,輝達的 GPU 已經千金難求。輝達先前也表示,兩年一發布的架構節奏將轉變為一年一發布。輝達的高階晶片價值連城,已經成為貸款的抵押品。

至於 H200 系統,輝達表示預計明年第二季上市。同在明年,輝達也將發表基於 Blackwell 架構的 B100,並計劃在 2024 年將 H100 的產量增加兩倍,目標是生產 200 多萬塊 H100。

當前熱搜:11億校產全捐國家 修平科大宣布停招 擬併國立暨南大學

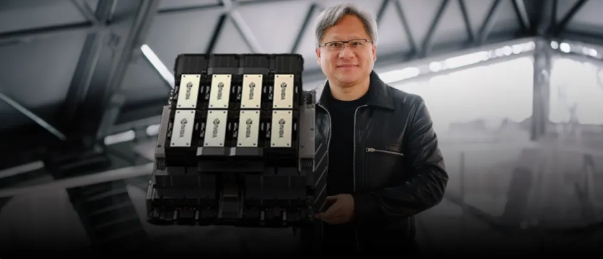

而在記者會上,輝達甚至全程沒有提任何競爭對手,只是不斷強調「輝達的 AI 超級運算平台,能夠更快地解決世界上一些最重要的挑戰。」

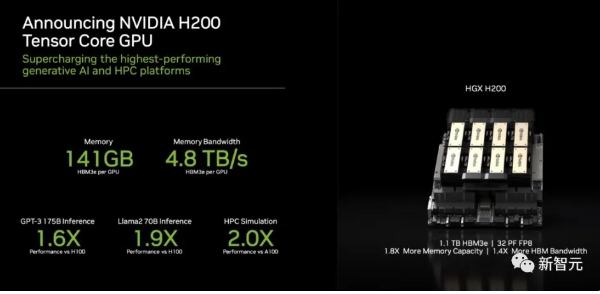

隨著生成式 AI 的大爆炸,需求只會更大,而且,這還沒算是 H200。141GB 超大記憶體,效能直接翻倍 H200 將為全球領先的 AI 運算平台增添動力。

它基於 Hopper 架構,配備輝達 H200 Tensor Core GPU 可以為生成式 AI 和高效能運算工作負載處理大量資料。

輝達 H200 是首款採用 HBM3e 的GPU。與 A100 相比,H200 的容量幾乎翻了一番,頻寬也增加了 2.4 倍。與 H100 相比,H200 的頻寬則從 3.35TB/s 增加到了 4.8TB/s。

輝達大規模與高效能運算副總裁 Ian Buck 表示,要利用生成式人工智慧和高效能運算應用創造智能,必須使用大型、快速的 GPU 記憶體,以高速高效地處理大量資料。借助 H200,業界領先的端到端人工智慧超算平台的速度會變得更快,一些世界上最重要的挑戰,都可以被解決。

輝達(NVIDIA)H200晶片 圖 : 翻攝自騰訊網/新智元

輝達 H200 是首款採用 HBM3e的GPU。 圖 : 翻攝自騰訊網/新智元